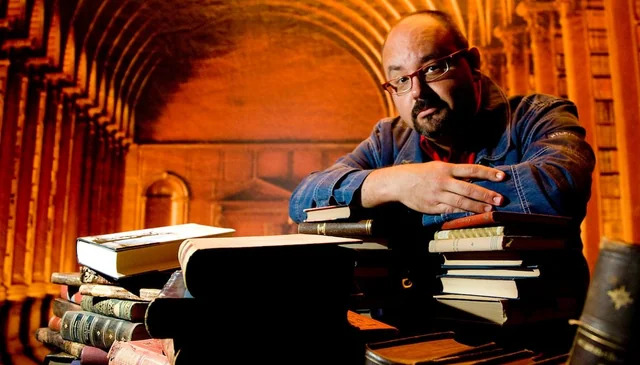

Охота на электроовец. Большая книга искусственного интеллекта - Сергей Сергеевич Марков

Книгу Охота на электроовец. Большая книга искусственного интеллекта - Сергей Сергеевич Марков читаем онлайн бесплатно полную версию! Чтобы начать читать не надо регистрации. Напомним, что читать онлайн вы можете не только на компьютере, но и на андроид (Android), iPhone и iPad. Приятного чтения!

Шрифт:

Интервал:

Закладка:

2583

Liu X., Zheng Y., Du Z., Ding M., Qian Y., Yang Z., Tang J. (2021). GPT Understands, Too // https://arxiv.org/abs/2103.10385

2584

Lester B., Al-Rfou R., Constant N. (2021). The Power of Scale for Parameter-Efficient Prompt Tuning // https://arxiv.org/abs/2104.08691

2585

Конодюк Н. (2021). Управляем генерацией ruGPT-3: библиотека ruPrompts / Хабр, 17 декабря 2021 // https://habr.com/ru/company/sberdevices/blog/596103/

2586

* Чего стоит хотя бы такой пассаж: «Кроме того, Пугачёва раскрыла подробности своей биографии, в которой оказалось немало скандальных эпизодов. Например, она утверждала, что в молодости была гейшей, а также что у неё в шкафу хранился сухой паёк на случай атомной войны, а её зять Г. Л. Рамазанов открыл для себя ясновидение».

2587

Larson D. (2013). Irritant. Blue Square Press // https://books.google.ru/books?id=lOdOmwEACAAJ

2588

Green O. (2020). Bob The Robot: Exploring the Universe — A Cozy Bedtime Story Produced by Artificial Intelligence. Kindle Edition // https://www.amazon.com/Bob-Robot-Exploring-Artificial-Intelligence-ebook/dp/B08GL2YWGY

2589

Green O. (2020). How to write and publish a book using Machine Learning (GPT-3) // https://www.youtube.com/watch?v=oKh_Jxfeae0

2590

Пепперштейн Н., Пепперштейн П. (2022). Пытаясь проснуться // https://www.litres.ru/book/neyro-peppershteyn/pytayas-prosnutsya-68292629/

2591

Шаврина Т. (2022). Это наконец произошло: нейросеть и человек написали книгу. Вместе! Рассказываем, как им помогали разработчики. / Хабр, 25 мая 2022 // https://habr.com/ru/companies/sberdevices/articles/667582/

2592

Thompson D. A. (2022). Books by AI (GPT-3, GPT-3.5, ChatGPT) / LifeArchitect.ai // https://lifearchitect.ai/books-by-ai/

2593

Branwen G. (2020). GPT-3 Creative Fiction // https://www.gwern.net/GPT-3

2594

Аверкиев С. (2023). Сбер открывает доступ к нейросетевой модели ruGPT-3.5 / Хабр, 20 июля 2023 // https://habr.com/ru/companies/sberbank/articles/746736/

2595

Аверкиев С. (2023). Это не чат, это GigaChat. Русскоязычная ChatGPT от Сбера / Хабр, 24 апреля 2023 // https://habr.com/ru/companies/sberbank/articles/730108/

2596

Zmitrovich D., Abramov A., Kalmykov A., Tikhonova M., Taktasheva E., Astafurov D., Baushenko M., Snegirev A., Shavrina T., Markov S., Mikhailov V., Fenogenova A. (2023). A Family of Pretrained Transformer Language Models for Russian // https://arxiv.org/abs/2309.10931

2597

Shliazhko O., Fenogenova A., Tikhonova M., Mikhailov V., Kozlova A., Shavrina T. (2022). mGPT: Few-Shot Learners Go Multilingual // https://arxiv.org/abs/2204.07580

2598

Ruder S. (2023). The State of Multilingual AI // https://www.ruder.io/state-of-multilingual-ai/

2599

Devlin J., Chang M.-W., Lee K., Toutanova K. (2018). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding // https://arxiv.org/abs/1810.04805

2600

Conneau A., Khandelwal K., Goyal N., Chaudhary V., Wenzek G., Guzmán F., Grave E., Ott M., Zettlemoyer L., Stoyanov V. (2019). Unsupervised Cross-lingual Representation Learning at Scale // https://arxiv.org/abs/1911.02116

2601

Lin X. V., Mihaylov T., Artetxe M., Wang T., Chen S., Simig D., Ott M., Goyal N., Bhosale S., Du J., Pasunuru R., Shleifer S., Koura P. S., Chaudhary V., O'Horo B., Wang J., Zettlemoyer L., Kozareva Z., Diab M., Stoyanov V., Li X. (2021). Few-shot Learning with Multilingual Language Models // https://arxiv.org/abs/2112.10668

2602

Raffel C., Shazeer N., Roberts A., Lee K., Narang S., Matena M., Zhou Y., Li W., Liu P. J. (2019). Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer // https://arxiv.org/abs/1910.10683

2603

Xue L., Constant N., Roberts A., Kale M., Al-Rfou R., Siddhant A., Barua A., Raffel C. (2020). mT5: A massively multilingual pre-trained text-to-text transformer // https://arxiv.org/abs/2010.11934

2604

Aribandi V., Tay Y., Schuster T., Rao J., Zheng H. S., Mehta S. V., Zhuang H., Tran V. Q., Bahri D., Ni J., Gupta J., Hui K., Ruder S., Metzler D. (2021). ExT5: Towards Extreme Multi-Task Scaling for Transfer Learning // https://arxiv.org/abs/2111.10952

2605

Rae J., Irving G., Weidinger L. (2021). Language modelling at scale: Gopher, ethical considerations, and retrieval / DeepMind blog, 08 Dec 2021 // https://deepmind.com/blog/article/language-modelling-at-scale

2606

Chen W., Hu H., Saharia C., Cohen W. W. (2022). Re-Imagen: Retrieval-Augmented Text-to-Image Generator // https://arxiv.org/abs/2209.14491

2607

Fedus W., Zoph B., Shazeer N. (2021). Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity // https://arxiv.org/abs/2101.03961

2608

Lepikhin D., Lee H., Xu Y., Chen D., Firat O., Huang Y., Krikun M., Shazeer N., Chen Z. (2020). GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding // https://arxiv.org/abs/2006.16668

2609

Jacobs R. A., Jordan M. I., Nowlan S. J., Hinton G. E. (1991). Adaptive Mixtures of Local Experts // http://www.cs.toronto.edu/~fritz/absps/jjnh91.pdf

2610

Shazeer N., Mirhoseini A., Maziarz K., Davis A., Le Q., Hinton G., Dean J. (2017). Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer // https://arxiv.org/abs/1701.06538

2611

Kim Y. J., Awan A. A., Muzio A., Salinas A. F. C., Lu L., Hendy A., Rajbhandari S., He Y., Awadalla H. H. (2021). Scalable and Efficient MoE Training for Multitask Multilingual Models // https://arxiv.org/abs/2109.10465

2612

Du N., Huang Y., Dai A. M., Tong S., Lepikhin D., Xu Y., Krikun M., Zhou Y., Yu A. W., Firat O., Zoph B., Fedus L., Bosma M., Zhou Z., Wang T., Wang Y. E., Webster K., Pellat M., Robinson K., Meier-Hellstern K., Duke T., Dixon L., Zhang K., Le Q. V., Wu Y., Chen Z., Cui C. (2021). GLaM: Efficient Scaling of Language Models with Mixture-of-Experts // https://arxiv.org/abs/2112.06905

2613

Artetxe M., Bhosale S., Goyal N., Mihaylov T., Ott M., Shleifer S., Lin X. V., Du J., Iyer S., Pasunuru R., Anantharaman G., Li X., Chen S., Akin H., Baines M., Martin

Прочитали книгу? Предлагаем вам поделится своим отзывом от прочитанного(прослушанного)! Ваш отзыв будет полезен читателям, которые еще только собираются познакомиться с произведением.

Уважаемые читатели, слушатели и просто посетители нашей библиотеки! Просим Вас придерживаться определенных правил при комментировании литературных произведений.

- 1. Просьба отказаться от дискриминационных высказываний. Мы защищаем право наших читателей свободно выражать свою точку зрения. Вместе с тем мы не терпим агрессии. На сайте запрещено оставлять комментарий, который содержит унизительные высказывания или призывы к насилию по отношению к отдельным лицам или группам людей на основании их расы, этнического происхождения, вероисповедания, недееспособности, пола, возраста, статуса ветерана, касты или сексуальной ориентации.

- 2. Просьба отказаться от оскорблений, угроз и запугиваний.

- 3. Просьба отказаться от нецензурной лексики.

- 4. Просьба вести себя максимально корректно как по отношению к авторам, так и по отношению к другим читателям и их комментариям.

Надеемся на Ваше понимание и благоразумие. С уважением, администратор knigkindom.ru.

Оставить комментарий

-

Гость Татьяна22 февраль 23:20

Спасибо автору. Интересно. Написано без пошлости. ...

Насквозь - Таша Строганова

Гость Татьяна22 февраль 23:20

Спасибо автору. Интересно. Написано без пошлости. ...

Насквозь - Таша Строганова

-

Юрий22 февраль 18:40

телеграм автора: t.me/main_yuri...

Юрий А. - Фестиваль

Юрий22 февраль 18:40

телеграм автора: t.me/main_yuri...

Юрий А. - Фестиваль

-

Гость Наталья20 февраль 13:16

Не плохо.Сюжет увлекательный. ...

По следам исчезнувших - Лена Александровна Обухова

Гость Наталья20 февраль 13:16

Не плохо.Сюжет увлекательный. ...

По следам исчезнувших - Лена Александровна Обухова