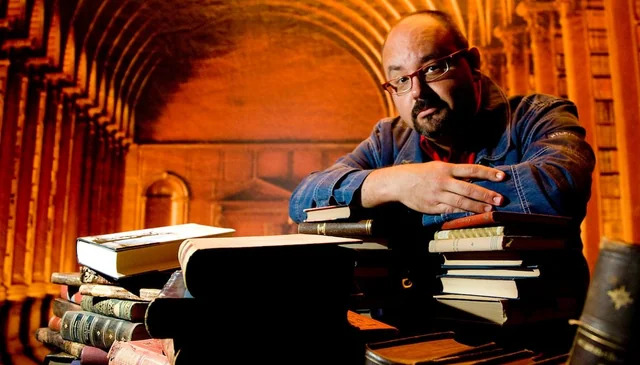

Охота на электроовец. Большая книга искусственного интеллекта - Сергей Сергеевич Марков

Книгу Охота на электроовец. Большая книга искусственного интеллекта - Сергей Сергеевич Марков читаем онлайн бесплатно полную версию! Чтобы начать читать не надо регистрации. Напомним, что читать онлайн вы можете не только на компьютере, но и на андроид (Android), iPhone и iPad. Приятного чтения!

Шрифт:

Интервал:

Закладка:

2614

Schreiner M. (2023). GPT-4 architecture, datasets, costs and more leaked. / The Decoder, Jul. 11, 2023. // https://the-decoder.com/gpt-4-architecture-datasets-costs-and-more-leaked/

2615

Zeng W., Ren X., Su T., Wang H., Liao Y., Wang Z., Jiang X., Yang Z., Wang K., Zhang X., Li C., Gong Z., Yao Y., Huang X., Wang J., Yu J., Guo Q., Yu Y., Zhang Y., Wang J., Tao H., Yan D., Yi Z., Peng F., Jiang F., Zhang H., Deng L., Zhang Y., Lin Z., Zhang C., Zhang S., Guo M., Gu S., Fan G., Wang Y., Jin X., Liu Q., Tian Y. (2021). PanGu-α: Large-scale Autoregressive Pretrained Chinese Language Models with Auto-parallel Computation // https://arxiv.org/abs/2104.12369

2616

Du C. (2021). Chinese AI lab challenges Google, OpenAI with a model of 1.75 trillion parameters / PingWest, June 1, 2021 // https://en.pingwest.com/a/8693

2617

Lin J., Yang A., Bai J., Zhou C., Jiang L., Jia X., Wang A., Zhang J., Li Y., Lin W., Zhou J., Yang H. (2021). M6-10T: A Sharing-Delinking Paradigm for Efficient Multi-Trillion Parameter Pretraining // https://arxiv.org/abs/2110.03888

2618

Ma Z., He J., Qiu J., Cao H., Wang Y., Sun Z., Zheng L., Wang H., Tang S., Zheng T., Lin J., Feng G., Huang Z., Gao J., Zeng A., Zhang J., Zhong R., Shi T., Liu S., Zheng W., Tang J., Yang H., Liu X., Zhai J., Chen W. (2022). BaGuaLu: targeting brain scale pretrained models with over 37 million cores // PPoPP '22: Proceedings of the 27th ACM SIGPLAN Symposium on Principles and Practice of Parallel Programming, pp. 192–204. // https://doi.org/10.1145/3503221.3508417

2619

* BaGuaLu (八卦炉), печь восьми триграмм (восьми гуа), волшебная печь из древнекитайской мифологии, позволяющая создавать эффективные лекарства. Восемь триграмм гуа используются в даосской космологии, чтобы представить фундаментальные принципы бытия.

2620

Lin J., Men R., Yang A., Zhou C., Ding M., Zhang Y., Wang P., Wang A., Jiang L., Jia X., Zhang J., Zhang J., Zou X., Li Z., Deng X., Liu J., Xue J., Zhou H., Ma J., Yu J., Li Y., Lin W., Zhou J., Tang J., Yang H. (2021). M6: A Chinese Multimodal Pretrainer // https://arxiv.org/abs/2103.00823

2621

Kharya P., Alvi A. (2021). Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, the World’s Largest and Most Powerful Generative Language Model / Nvidia Developer Blog, Oct 11, 2021 // https://developer.nvidia.com/blog/using-deepspeed-and-megatron-to-train-megatron-turing-nlg-530b-the-worlds-largest-and-most-powerful-generative-language-model/

2622

Smith S., Patwary M., Norick B., LeGresley P., Rajbhandari S., Casper J., Liu Z., Prabhumoye S., Zerveas G., Korthikanti V., Zhang E., Child R., Aminabadi R. Y., Bernauer J., Song X., Shoeybi M., He Y., Houston M., Tiwary S., Catanzaro B. (2022). Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, A Large-Scale Generative Language Model // https://arxiv.org/abs/2201.11990

2623

Almazrouei E., Alobeidli H., Alshamsi A., Cappelli A., Cojocaru R., Alhammadi M., Mazzotta D., Heslow D., Launay J., Malartic Q., Noune B., Pannier B., Penedo G. (2023). The Falcon Series of Language Models: Towards Open Frontier Models // https://huggingface.co/tiiuae/falcon-180B

2624

Le Scao T., Fan A., Akiki C., Pavlick E., Ilić S., Hesslow D., Castagné R., Luccioni A. S., Yvon F., Gallé M., Tow J., Rush A. M., Biderman S., Webson A., Ammanamanchi P. S., Wang T., Sagot B., Muennighoff N., Moral A. V. d., Ruwase O., Bawden R., Bekman S., McMillan-Major A., Beltagy I., Nguyen H., Saulnier L., Tan S., Suarez P. O., Sanh V., Laurençon H., Jernite Y., Launay J., Mitchell M., Raffel C., Gokaslan A., Simhi A., Soroa A., Aji A. F., Alfassy A., Rogers A., Nitzav A. K., Xu C., Mou C., Emezue C., Klamm C., Leong C., Strien D. v., Adelani D. I., Radev D., Ponferrada E. G., Levkovizh E., Kim E., Natan E. B., Toni F. D., Dupont G., Kruszewski G., Pistilli G., Elsahar H., Benyamina H., Tran H., Yu I., Abdulmumin I., Johnson I., Gonzalez-Dios I., Rosa J. d. l., Chim J., Dodge J., Zhu J., Chang J., Frohberg J., Tobing J., Bhattacharjee J., Almubarak K., Chen K., Lo K., Von Werra L., Weber L., Phan L., allal L. B., Tanguy L., Dey M., Muñoz M. R., Masoud M., Grandury M., Šaško M., Huang M., Coavoux M., Singh M., Jiang M. T., Vu M. C., Jauhar M. A., Ghaleb M., Subramani N., Kassner N., Khamis N., Nguyen O., Espejel O., Gibert O. d., Villegas P., Henderson P., Colombo P., Amuok P., Lhoest Q., Harliman R., Bommasani R., López R. L., Ribeiro R., Osei S., Pyysalo S., Nagel S., Bose S., Muhammad S. H., Sharma S., Longpre S., Nikpoor S., Silberberg S., Pai S., Zink S., Torrent T. T., Schick T., Thrush T., Danchev V., Nikoulina V., Laippala V., Lepercq V., Prabhu V., Alyafeai Z., Talat Z., Raja A., Heinzerling B., Si C., Taşar D. E., Salesky E., Mielke S. J., Lee W. Y., Sharma A., Santilli A., Chaffin A., Stiegler A., Datta D., Szczechla E., Chhablani G., Wang H., Pandey H., Strobelt H., Fries J. A., Rozen J., Gao L., Sutawika L., Bari M. S., Al-shaibani M. S., Manica M., Nayak N., Teehan R., Albanie S., Shen S., Ben-David S., Bach S. H., Kim T., Bers T., Fevry T., Neeraj T., Thakker U., Raunak V., Tang X., Yong Z., Sun Z., Brody S., Uri Y., Tojarieh H., Roberts A., Chung H. W., Tae J., Phang J., Press O., Li C., Narayanan D., Bourfoune H., Casper J., Rasley J., Ryabinin M., Mishra M., Zhang M., Shoeybi M., Peyrounette M., Patry N., Tazi N., Sanseviero O., von Platen P., Cornette P., Lavallée P. F., Lacroix R., Rajbhandari S., Gandhi S., Smith S., Requena

Прочитали книгу? Предлагаем вам поделится своим отзывом от прочитанного(прослушанного)! Ваш отзыв будет полезен читателям, которые еще только собираются познакомиться с произведением.

Уважаемые читатели, слушатели и просто посетители нашей библиотеки! Просим Вас придерживаться определенных правил при комментировании литературных произведений.

- 1. Просьба отказаться от дискриминационных высказываний. Мы защищаем право наших читателей свободно выражать свою точку зрения. Вместе с тем мы не терпим агрессии. На сайте запрещено оставлять комментарий, который содержит унизительные высказывания или призывы к насилию по отношению к отдельным лицам или группам людей на основании их расы, этнического происхождения, вероисповедания, недееспособности, пола, возраста, статуса ветерана, касты или сексуальной ориентации.

- 2. Просьба отказаться от оскорблений, угроз и запугиваний.

- 3. Просьба отказаться от нецензурной лексики.

- 4. Просьба вести себя максимально корректно как по отношению к авторам, так и по отношению к другим читателям и их комментариям.

Надеемся на Ваше понимание и благоразумие. С уважением, администратор knigkindom.ru.

Оставить комментарий

-

Гость Татьяна22 февраль 23:20

Спасибо автору. Интересно. Написано без пошлости. ...

Насквозь - Таша Строганова

Гость Татьяна22 февраль 23:20

Спасибо автору. Интересно. Написано без пошлости. ...

Насквозь - Таша Строганова

-

Юрий22 февраль 18:40

телеграм автора: t.me/main_yuri...

Юрий А. - Фестиваль

Юрий22 февраль 18:40

телеграм автора: t.me/main_yuri...

Юрий А. - Фестиваль

-

Гость Наталья20 февраль 13:16

Не плохо.Сюжет увлекательный. ...

По следам исчезнувших - Лена Александровна Обухова

Гость Наталья20 февраль 13:16

Не плохо.Сюжет увлекательный. ...

По следам исчезнувших - Лена Александровна Обухова